Au commencement

Il y a quelques années — époque « préhistoweb » — j’ai rencontré en ligne Daniel, un graphiste, qui venait de lancer wearpalettes.com (vip.wearpalettes.com). Le principe était simple et séduisant.

Chaque matin, à tour de rôle, nous choisissions la photo d’une célébrité, en extrayions manuellement les couleurs dominantes, puis publiions le résultat sous forme de nuancier.

Simple, ludique et addictif, ce projet a connu un certain succès avant de disparaître dans le flot du web, mais l’idée ne m’a jamais quitté.

Réappropriation académique (2013)

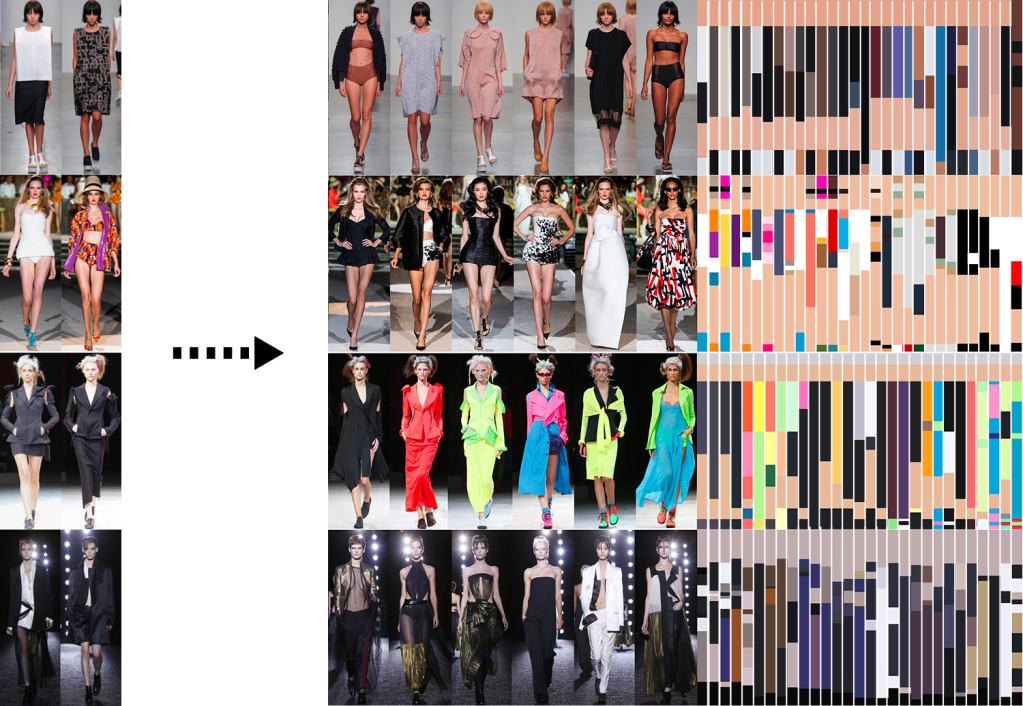

Plus tard, j’ai repris ce principe dans un cours de création graphique axé sur la mode. Les étudiants observaient les images de défilés, isolaient à l’œil les couleurs dominantes de chaque silhouette dans Adobe Photoshop, puis les reportaient sous forme de « carottes de couleur ».

Plus tard j’ai été aussi inspiré par une étude de Peihua Lai (2018, université de Leeds) — qui utilisait un algorithme pour cette même tâche — alors que nous accomplissions tout manuellement pour au final produire un véritable catalogue chromatique saisonnier, un outil digne d’un bureau de tendance.

On pouvait observer la tendance couleur d’une marque, mais aussi la répartition chronologique des tons, les nuances, les volumes (selon que l’on voit plus ou moins de peau), etc.

ex. ci-dessus le gros plan montre sur la seconde ligne, 50% de couleur chair notamment dans la partie basse de la silhouette témoignant d’une collection avec beaucoup de vêtements courts.

Le défi

L’étape suivante était claire : automatiser le processus. Je voulais développer une application capable, à partir d’une photo et de paramètres définis, de générer une palette de couleurs sans intervention humaine.

Cela impliquait d’apprendre à coder…

Sans dé-coder

Les années sont passées, je n’ai jamais appris à coder.

Puis l’intelligence artificielle générative (IA) a transformé cette ambition en possibilité concrète. Nos conversations m’ont permis de dicter les fonctionnalités de l’application.

Mais cette facilité apparente, comme toujours avec l’IA, suppose une rigueur extrême : un cahier des charges détaillé (interface, interactions, résultats attendus) est indispensable pour contraindre l’IA à ne pas s’égarer.

Subjectivité vs analyse brute

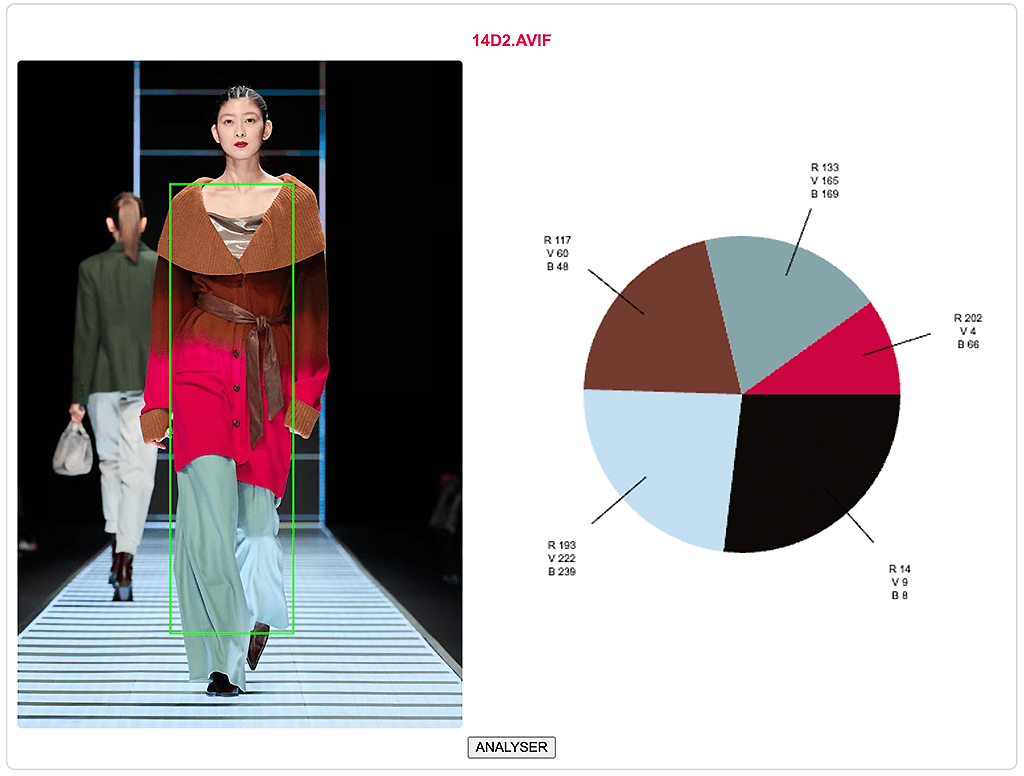

Lors des premiers tests et dans ce cas précis, un obstacle majeur est rapidement apparu : l’IA analysait la distribution brute des pixels, alors que ma perception privilégiait certaines zones d’intérêt.

Par exemple, sur la photo de gauche ci-dessous, tandis que l’IA retient le noir, l’ocre et le blanc — l’ocre correspondant à la moyenne du fond, mon œil capte le blanc, le jaune d’or et le noir.

Pour corriger cela, il y a eu beaucoup de questions quasi-métaphysiques (!). J’ai affiné mes instructions et l’IA m’a proposé d’intégrer des fonctions comme BodyPix, K‑means et j’ai proposé d’ajouter en plus une fonction pondérant le centre de l’image (zone où se trouve généralement le sujet principal).

Une fois ces fonctions activées (à droite) le résultat est plus… humain.

Version bêta

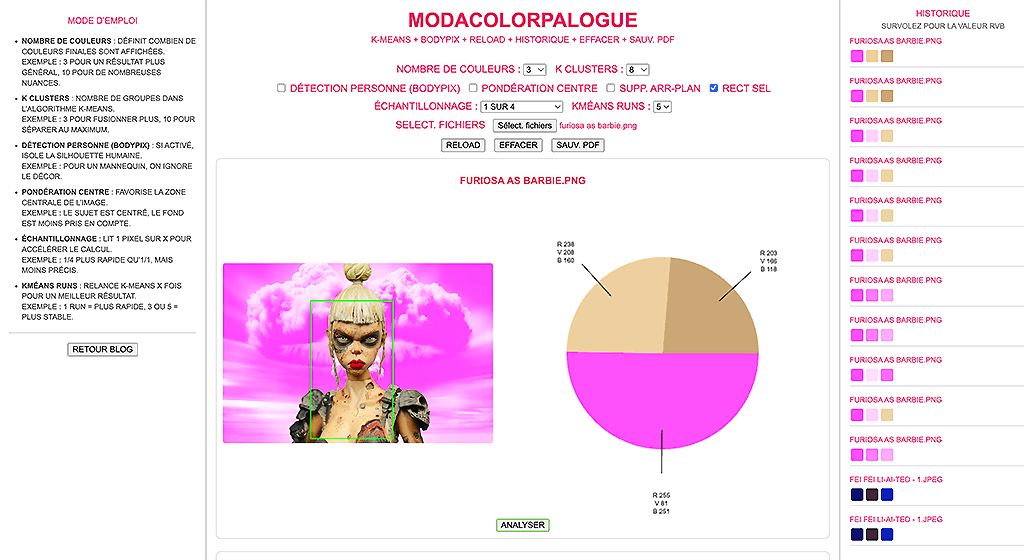

La première version « publiable » de l’application fonctionnait presque comme imaginé. Au fil des itérations, j’ai ajouté des fonctionnalités (sélection de zone, création de palette, export PDF, mode d’emploi, timer…).

Mais ces ajouts non prévus confirment l’importance d’un cahier des charges exhaustif et de sauvegardes régulières. En l’occurence après des jours de test je m’aperçois que le poids des couleurs dans le camembert perturbe l’interprétation du résultat. Les vignettes de droite suffiraient.

Outre les « conflits entre les fonctions, le code peut devenir rapidement instable, générant erreurs et conflits et peut devenir irrécupérable. Sans compter un autre problème de taille (même avec mon abonnement à chatGPT plus) qui est le nombre volumineux de token sollicités, qui à terme ralenti considérablement ChatGPT et freeze le navigateur.

Le Modacolorpalogue

Le résultat final, baptisé Modacolorpalogue (accessible dans le menu du blog), compte environ 800 lignes de code écrites en moins de trois jours — sans aucune expérience préalable en programmation. Coder avec l’IA est aussi accessible que de créer des images et l’application offre une solution automatisée pour extraire des palettes de couleurs fidèles à la perception humaine à partir d’une simple photo.

L’application certes reste assez geek, il reste des bugs, mais très personnalisable et il ne faut pas hésiter à en manipuler toutes les options.

L’IA générative accélère la créativité en transformant rapidement idées en prototypes, mais exige une certaine préparation, des objectifs précis et effort continu pour préserver la part irremplaçable de subjectivité et de sensibilité humaine. Plus qu’un substitut, elle se révèle un partenaire de co‑création.